Относительная погрешность – важный показатель точности измерений и вычислений. Она позволяет определить, насколько результат нашего эксперимента или расчета отличается от истинного значения. Относительная погрешность выражается в процентах и позволяет сравнить полученный результат с допустимой погрешностью, установленной для данного измерения или расчета.

Определение относительной погрешности является важнейшим этапом в любом исследовании или проекте. Она позволяет оценить степень достоверности наших результатов и выявить возможные ошибки или неточности в проведении измерений или вычислений.

Если относительная погрешность оказывается значительно больше допустимой погрешности, это может свидетельствовать о недостаточной точности измерительных приборов, ошибке методики измерения или некорректном выполнении расчетов. Важно уметь правильно определить относительную погрешность и учесть ее в дальнейших исследованиях или расчетах, чтобы получить достоверные и репрезентативные результаты.

Относительная погрешность: понятие и определение

Относительная погрешность выражается в процентах и показывает, насколько отличается измеренное или вычисленное значение от эталонного значения. Она является отношением абсолютной погрешности к значению эталона. Чем меньше относительная погрешность, тем более точными считаются результаты измерений или вычислений.

Для определения относительной погрешности необходимо знать как само измеренное значение, так и точное значение эталона или ожидаемый результат. Относительная погрешность вычисляется по следующей формуле:

Относительная погрешность (%) = (Абсолютная погрешность / Значение эталона) * 100

Где абсолютная погрешность — это разность между измеренным или вычисленным значением и эталонным значением.

Относительная погрешность позволяет оценить точность результатов измерений или вычислений. Она является важным показателем в научных и технических областях, где требуется высокая точность и надежность данных.

Что означает относительная погрешность?

Относительная погрешность выражается в процентах и показывает, какое максимальное отклонение от идеального значения может быть при проведении измерений или вычислений. Чем меньше процент относительной погрешности, тем более точными являются полученные результаты.

Определение относительной погрешности осуществляется путем деления абсолютной погрешности на истинное или ожидаемое значение, а затем умножения на 100%.

Для наглядного представления и анализа погрешностей результатов измерений и вычислений часто используется таблица, в которой отображаются значения, абсолютные погрешности и относительные погрешности. Такая таблица позволяет быстро и легко сравнить точность разных результатов и оценить, какие из них более достоверные.

| Значение | Абсолютная погрешность | Относительная погрешность |

|---|---|---|

| 10 | 0.5 | 5% |

| 15 | 0.2 | 1.3% |

| 20 | 0.3 | 1.5% |

В приведенной таблице можно увидеть, что относительная погрешность для первого значения составляет 5%, для второго — 1.3%, а для третьего — 1.5%. Это означает, что первый результат имеет большую погрешность и меньшую точность по сравнению с остальными двумя.

Определение относительной погрешности

Для определения относительной погрешности необходимо знать точное значение величины (или истинное значение) и приближенное значение. Относительная погрешность вычисляется по формуле:

Относительная погрешность = (Приближенное значение — Точное значение) / Точное значение

Вычисленное значение относительной погрешности можно выразить в процентах, умножив его на 100. Чем меньше значение относительной погрешности, тем более точным считается результат измерения или приближение.

Относительная погрешность позволяет оценить адекватность результатов исследования, прогноза или моделирования, и может быть использована для сравнения различных методов и приближений. Она помогает исследователям и инженерам определить, насколько можно доверять полученным результатам и принимать решения на основе этих результатов.

Таким образом, определение относительной погрешности позволяет оценить точность результатов измерений или приближений и принять во внимание возможные погрешности при дальнейшем анализе и использовании этих результатов.

Почему важно измерять относительную погрешность?

Измерение относительной погрешности важно потому, что позволяет оценить точность измерений и сравнивать их между собой. Она позволяет определить, насколько достоверны результаты эксперимента и с какой вероятностью они отражают действительность.

Знание относительной погрешности помогает ученым и инженерам принять взвешенные решения на основе полученных данных. При анализе результатов эксперимента или при разработке новых технологий необходимо знать, насколько точны измерения и насколько можно доверять полученным результатам.

Измерение относительной погрешности также помогает проводить сравнение различных методов измерений или разных инструментов. Например, при выборе измерительного прибора или при сравнении работы разных лабораторий важно знать, насколько точны и надежны они.

При работе со сложными системами или великими объемами данных, даже небольшая погрешность может приводить к значительным ошибкам. Поэтому измерение относительной погрешности является неотъемлемой частью любого эксперимента или измерения.

| Причины измерения относительной погрешности | Преимущества |

|---|---|

| Оценка точности измерений | Позволяет сравнить результаты разных измерений и определить, насколько они согласуются друг с другом. |

| Сравнение разных методов | Позволяет выбрать наиболее точный и надежный метод измерения. |

| Определение доверительного интервала | Позволяет оценить степень уверенности в полученных результатах и принять взвешенные решения на основе этой информации. |

| Минимизация систематических ошибок | Помогает выявить и устранить возможные источники ошибок и повысить точность измерений. |

В конечном итоге, измерение относительной погрешности является ключевым аспектом научных и инженерных исследований, которое позволяет обеспечить качество и достоверность полученных результатов.

Роль относительной погрешности в научных и инженерных расчётах

Относительная погрешность выражается в виде процентов и является отношением абсолютной погрешности к значению измеренной величины или результату расчёта. Она позволяет судить о влиянии погрешностей входных данных или измерительных приборов на конечный результат.

В научных исследованиях относительная погрешность часто используется для оценки достоверности полученных результатов. Если относительная погрешность невелика, то это свидетельствует о хорошей точности и надёжности расчётов. Если же относительная погрешность существенно превышает допустимый уровень, это может указывать на наличие систематических ошибок в расчётах или неудовлетворительное качество измерений.

В инженерной практике относительная погрешность позволяет оценить степень риска при принятии решений на основе полученных результатов. Если погрешность сильно влияет на конечный результат, то необходимо предпринять дополнительные меры для улучшения точности расчётов или измерений.

Относительная погрешность также играет важную роль при сравнении разных методов или моделей. С помощью неё можно сравнить эффективность различных методов расчёта или возможность использования разных моделей для определения показателей качества и надёжности конструкций или систем.

| Измеренное значение | Точное значение | Абсолютная погрешность | Относительная погрешность |

|---|---|---|---|

| 3.14 | 3.14159 | 0.00159 | 0.051% |

Практическое применение относительной погрешности

2. В инженерии. В процессе конструирования и проектирования различных механизмов и систем, относительная погрешность позволяет оценивать точность и надежность работы этих систем. Например, при разработке автоматизированных устройств, относительная погрешность помогает определить, насколько точно устройство может выполнять свои функции и управлять процессом.

3. В метрологии. Измерение и оценка погрешности — одна из важнейших задач в области метрологии. Относительная погрешность является основным показателем точности измерений и используется во всех областях, где требуется высокая точность измерений, например, в производстве и научных исследованиях.

4. В финансовых расчетах. В финансовой сфере, относительная погрешность может быть применена для определения точности и надежности финансовых прогнозов и моделей. Например, при прогнозировании доходности инвестиций или оценке стоимости активов, относительная погрешность помогает оценить точность прогнозов и принять обоснованные решения.

Таким образом, практическое применение относительной погрешности включает множество областей, начиная от научных исследований и инженерии, до метрологии и финансовых расчетов. Необходимость оценки относительной погрешности, помогает повысить точность и достоверность получаемых результатов и приносит пользу в решении различных задач и проблем.

Как определить относительную погрешность?

Для определения относительной погрешности необходимо знать, как измерялась или вычислялась величина, а также точное значение этой величины. Ниже приведены основные шаги для определения относительной погрешности:

- Определите точное значение величины или результат вычисления.

- Вычислите абсолютную погрешность, которая представляет разницу между измеренным или вычисленным значением и точным значением.

- Разделите абсолютную погрешность на точное значение и умножьте на 100% или просто представьте в виде десятичной дроби.

- Полученное значение будет являться относительной погрешностью и может быть выражено в процентах или десятичной форме.

Например, если измеренное значение равно 10, а точное значение составляет 9.5, абсолютная погрешность равна 0.5. Если мы разделим абсолютную погрешность на точное значение и умножим на 100%, то получим относительную погрешность 5%.

Используя относительную погрешность, мы можем оценить точность измерения или вычисления и сравнивать результаты различных измерений или вычислений. Более низкое значение относительной погрешности указывает на большую точность результата.

Методы расчёта относительной погрешности

Относительная погрешность позволяет измерить точность результатов измерений и вычислений. Существует несколько методов расчета относительной погрешности, которые позволяют определить, насколько результаты измерений или вычислений отличаются от истинных значений.

1. Метод абсолютных погрешностей:

Для расчета относительной погрешности по этому методу необходимо знать значение абсолютной погрешности истинного значения (δA) и значение измеряемой величины (A). Относительная погрешность (ε) рассчитывается по формуле:

ε = δA / A

2. Метод относительных погрешностей:

Для расчета относительной погрешности по этому методу необходимо знать относительные погрешности каждого измерения (ε1, ε2, …, εn). Относительная погрешность (ε) рассчитывается по формуле:

ε = sqrt(ε12 + ε22 + … + εn2)

3. Метод наименьших квадратов:

Этот метод применяется для нахождения наилучшей аппроксимации истинного значения в случае, когда имеется несколько измерений. При использовании метода наименьших квадратов находятся весовые коэффициенты, которые минимизируют сумму квадратов погрешностей между измеренными значениями и истинным значением. Погрешность рассчитывается по формуле:

ε = sqrt(Σ(y — mx — b)2 / (n — 2))

где y — измеренное значение, m — наклон, b — смещение, n — количество измерений.

Выбор метода расчета относительной погрешности зависит от типа измерения и характеристик измеряемой величины.

Примеры вычисления относительной погрешности

Рассмотрим несколько примеров, чтобы лучше понять, как вычислить относительную погрешность:

- Пример 1: Вычисление площади круга

- Пример 2: Вычисление среднего значения

- Пример 3: Вычисление процентного изменения

Предположим, что нам нужно вычислить площадь круга с радиусом 5 сантиметров. Используя формулу S = πr², получаем S = 3.14 * 5² = 78.5 сантиметров квадратных. Однако, точное значение площади круга равно 78.54 сантиметров квадратных. Разница между вычисленным значением и точным значением составляет 0.04 сантиметра квадратного. Для определения относительной погрешности нужно разделить эту разницу на точное значение и умножить на 100%. Относительная погрешность равна (0.04 / 78.54) * 100% = 0.051%.

Допустим, у нас есть набор данных: 5, 6, 7, 8, 9, 10. Необходимо вычислить среднее значение этого набора. Сумма всех чисел равна 45, а количество чисел — 6. Таким образом, среднее значение равно 45 / 6 = 7.5. Однако, точное значение среднего значения равно 7.83333. Разница между вычисленным значением и точным значением составляет 0.33333. Относительная погрешность определяется как (0.33333 / 7.83333) * 100% = 4.25%.

Пусть у нас есть начальное значение 100 и конечное значение 110. Чтобы вычислить процентное изменение, нужно вычислить разницу между конечным и начальным значениями (110 — 100 = 10) и разделить ее на начальное значение (10 / 100 = 0.1). Относительная погрешность равна 0.1 * 100% = 10%.

Все эти примеры демонстрируют, как вычислить относительную погрешность при различных вычислениях. Эта величина позволяет оценить точность результатов и определить, насколько они близки к точному значению.

Вопрос-ответ:

Что такое относительная погрешность и как её определить?

Относительная погрешность — это мера точности измерения или вычисления, выраженная в процентах. Она позволяет сравнить степень ошибки в измерениях или вычислениях относительно истинного значения. Определить относительную погрешность можно с помощью формулы, где разность между истинным значением и измеренным значением делится на истинное значение и умножается на 100%. Таким образом, мы получаем процентное значение относительной погрешности.

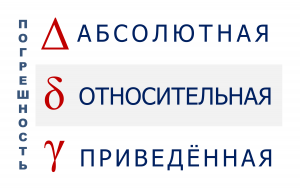

Какая разница между абсолютной и относительной погрешностями?

Абсолютная погрешность — это мера точности измерения или вычисления, выраженная в единицах измерения. Она показывает насколько измеренное значение отличается от истинного значения. Относительная погрешность, в свою очередь, выражается в процентах и отражает отношение абсолютной погрешности к истинному значению. Таким образом, разница состоит в единицах измерения и способе выражения погрешности.

Как относительная погрешность помогает оценить точность измерений?

Относительная погрешность позволяет оценить точность измерений, так как она выражает ошибку в процентах относительно истинного значения. Чем меньше значение относительной погрешности, тем более точное измерение. Если относительная погрешнсоть близка к нулю, значит, ошибки практически нет и измерение можно считать точным.

Можно ли определить относительную погрешность в процентах для нулевого значения?

Нет, невозможно вычислить относительную погрешность в процентах для нулевого значения. Это связано с тем, что формула для вычисления относительной погрешности содержит деление на истинное значение, а при нулевом значении деление на ноль невозможно. В таких случаях обычно используется абсолютная погрешность для оценки точности измерений.

Какие факторы могут влиять на относительную погрешность?

На относительную погрешность могут влиять различные факторы, включая инструменты измерения, методы измерений, человеческий фактор, окружающая среда и технические характеристики объекта измерения. Например, использование не точных измерительных приборов или неправильное применение метода измерения может привести к увеличению относительной погрешности. Также, изменение условий окружающей среды, как температура или влажность, может повлиять на точность измерений.